本文更新于: 2024年9月10日

APP喵前言:阿里最近推出了一个叫做QWen2-VL-7B的视觉语言模型,这家伙在OCR技术上简直是个明星。它能以100%的准确率识别英文手写体,而且对中文的处理也是一级棒!无论是学术研究还是日常应用,这个模型都是一个不可多得的好帮手。最棒的是,它还是开源的,这意味着大家都可以自由地使用和改进它。想要在文字识别上有所突破?快去了解一下QWen2-VL-7B吧!

网站简介

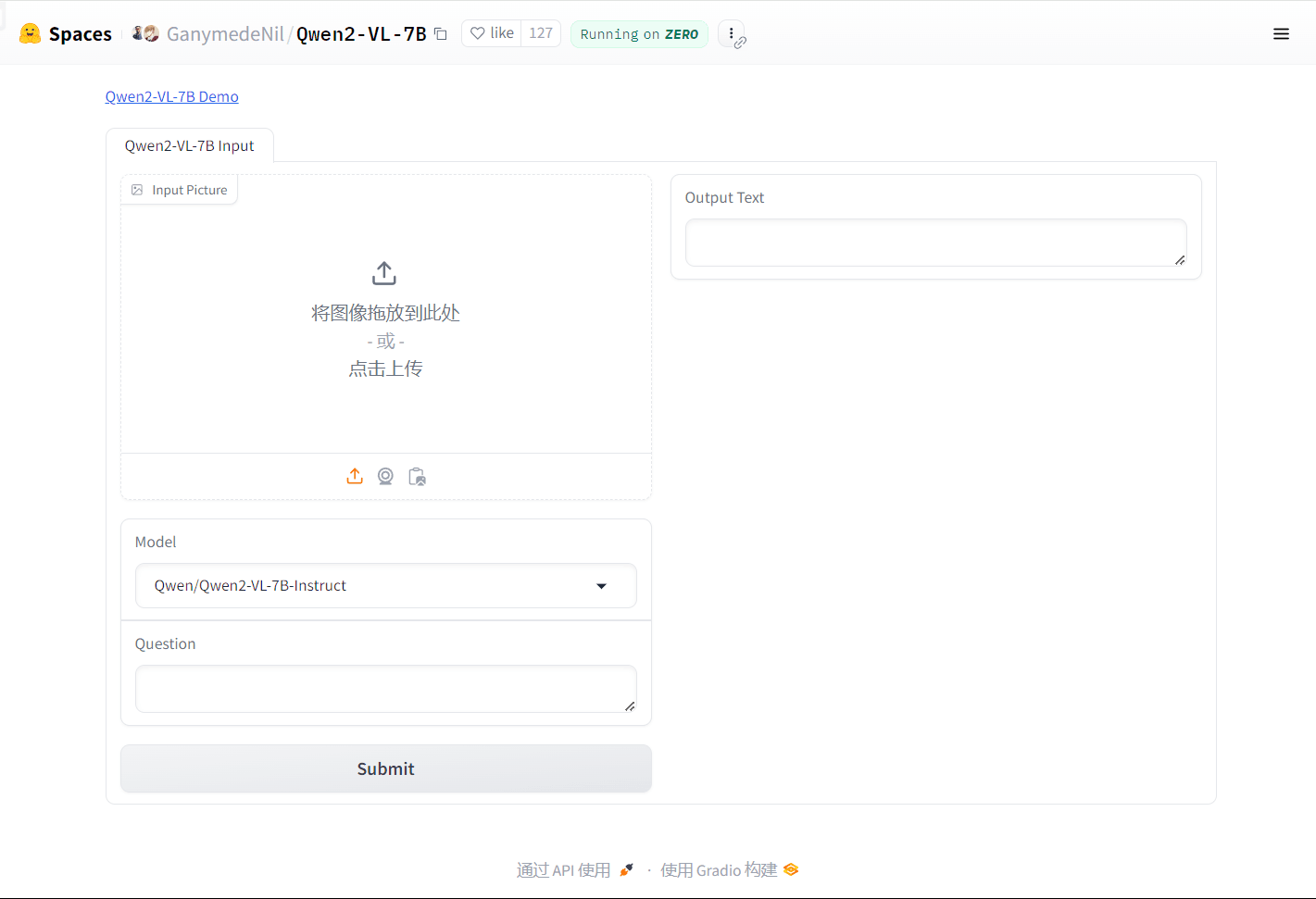

阿里发布了一款名为QWen2-VL-7B的视觉语言模型,该模型在OCR技术领域取得了显著成就,特别是在英文手写体识别上达到了100%的准确率,同时在中文识别方面也表现出色,达到了当前开源模型中的最佳水平。

截图

特色

- 高精度手写识别:英文手写体识别准确度达到100%,领先于同类开源模型。

- 出色的中文支持:在中文识别上也表现优异,能够处理复杂的中文字符。

- 视觉语言模型:结合了视觉和语言处理的能力,适用于多种图像识别和处理任务。

- 开源模型:作为开源模型,易于集成和使用,有助于推动社区的进一步研究和应用。

网站地址

https://huggingface.co/spaces/GanymedeNil/Qwen2-VL-7B

声明:本站为个人非盈利博客,资源均网络收集且免费分享无限制,无需登录。资源仅供测试学习,请于24小时内删除,任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集。请支持正版!如若侵犯了您的合法权益,可联系我们处理。